互联网应用与优化 - 互联网应用方案

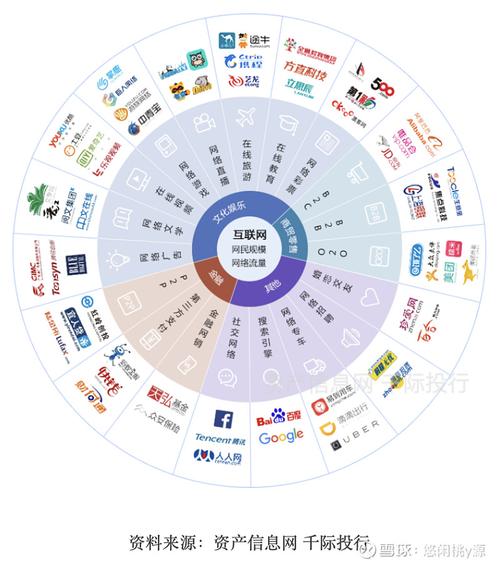

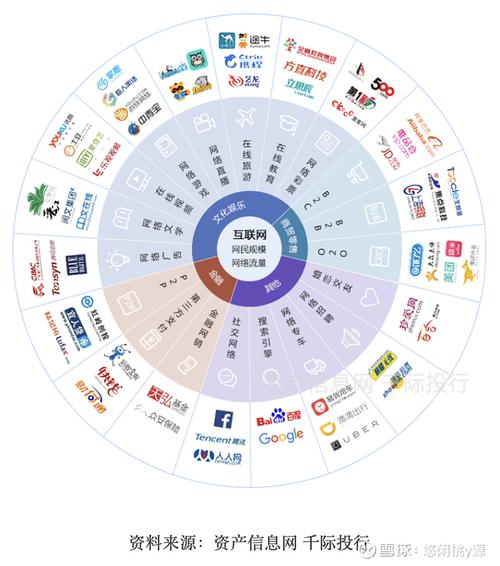

本文导读: 互联网领域有哪些方面『1』、互联网行业主要包括以下领域:互联网服务行业互联网服务行业是互联网行业的重要组成部分,涵盖了互联网服务提供商、云计算服务、数据中心等。这些服务为互联网用户提供了网络连接、数据存储和处理等核心功能。随着云计算和大数据技术的不断发展,互联网服务行业将继续保持快速增长。

互联网领域有哪些方面

『1』、互联网行业主要包括以下领域:互联网服务行业 互联网服务行业是互联网行业的重要组成部分,涵盖了互联网服务提供商、云计算服务、数据中心等。这些服务为互联网用户提供了网络连接、数据存储和处理等核心功能。随着云计算和大数据技术的不断发展,互联网服务行业将继续保持快速增长。

『2』、互联网服务行业:作为互联网技术与服务领域的核心,该行业包括互联网服务提供商和互联网应用服务提供商等。这些企业主要提供互联网基础设施服务、云计算、大数据服务等,为其他互联网行业的发展奠定了基础。 电子商务行业:电子商务利用互联网技术进行商业活动,涵盖B2B、B2C、C2C等多种模式。

『3』、“互联网+”现代农业:涵盖农林牧渔等领域,致力于通过互联网技术提升农业生产的现代化水平。 “互联网+”制造业:包括先进制造、智能硬件、工业自动化、生物医药、节能环保、新材料、军工等,旨在利用互联网推进制造业的创新发展。

『4』、互联网领域主要包括以下几个方面:基础技术 互联网技术是互联网领域的基础。这包括网络技术、云计算技术、大数据技术、人工智能技术等。网络技术是互联网的基础架构,使得各种设备和用户能够相互连接。云计算技术提供了强大的计算和存储能力,使得数据和信息能够在云端进行高效处理。

『5』、互联网行业的主要领域有: 电子商务行业 社交媒体和通讯行业 搜索引擎和在线广告行业 网络媒体与娱乐行业 云计算和大数据行业 软件开发与IT服务行业 下面,我们将详细解释这些领域:电子商务行业是互联网行业的重要组成部分,涵盖了在线购物、支付、物流等多个环节。

中国互联网发展的特点

移动互联网产业链更加细分,业务应用日益丰富,商业模式不断创新,带动了整个互联网产业和行业格局的加速 变革。三是互联网影响日益深化,行业间跨界融合不断加速,互联网作为技术平台,引领了新一轮的技术和产业革命,支撑两化融合不断深入发展, 带动传统的制造业生产方式的新变革。

初始阶段(1994年及以前):1994年,中国正式接入世界互联网,这一时期的互联网特点是上网流程繁琐,网速较慢,且网民数量极少。尽管如此,这一事件仍被视为中国互联网企业的起点。 发展阶段(2008年):到了2008年,中国的网民数量、宽带用户数量以及中文域名数量均居世界首位。

请归纳概括出我国互联网在不同发展阶段的特点?初始阶段,1994年中国接入世界互联网,这一阶段上网步骤复杂,网速慢,网民规模非常小,同时,开启了中国互联网企业的发展。

我国互联网发展有七大特征:第一个特征是互联网从“链接”向“连接”的转变。这也是COWMALS的前提。整个互联网站与站之间、网站跟用户之间的连接性发生了根本性变化,从相对轻的弱连接,向深度的数据交互的强连接转变,这是一个特征。

网络优化技术是什么意思?

网络优化技术是指利用网络技术和相关工具来提高网络性能和用户体验的一种方法。网络优化技术涵盖了很多方面,包括网络带宽优化、网络拓扑优化、网络协议优化、网络故障处理等。通过采用各种网络优化技术,可以提高网络的稳定性,降低网络故障率,缩短数据传输时间,提升用户的体验感和满意度。

网络优是网络优化的简称,它包含了一系列技术手段和管理方法,旨在提高网络质量和用户体验。网络优技术包括网络性能优化、网络带宽优化、网络安全优化等方面。随着信息技术的快速发展,网络已经成为人们生活和工作中必不可少的一部分,而网络质量的高低也直接影响到人们的体验和感受。因此,网络优化显得尤为重要。

综上所述,网络优化是一种为了提高网络性能和用户体验的技术。通过网络优化手段,我们能够提高网络效率和可靠性,同时降低网络的运营成本。网络优化是企业、用户和整个社会的共同利益,也是数字化生活不可或缺的组成部分。

“互联网+”在生活中有哪些应用?

军事应用:在军事领域,互联网能够实现实时发布和接收通讯指令,对于国防安全具有重要意义。 未来生活:互联网在未来的日常生活中将发挥更大作用,例如远程监控防盗系统,远程控制家电等,这些高科技产品和服务已经在一些先进家庭中得到应用。

信息获取:互联网是人们获取信息的主要渠道之一。通过搜索引擎、新闻网站、博客等,人们可以快速、方便地获取各种领域的信息,包括新闻、娱乐、教育、科技等。社交交流:互联网改变了人们的社交行为。通过社交媒体平台,人们可以与朋友、家人和全球各地的陌生人保持联系,并分享自己的生活、想法和观点。

学习:互联网提供了丰富的学习资源,用户可以在家中自学各种知识,涵盖学科广泛,满足不同学习需求。浏览:通过互联网,人们可以迅速了解全球动态,包括世界格局、世界形势、国家政策和地方新闻等,使信息获取变得前所未有地容易。

工作和军事应用:在军事领域,互联网实现了实时发布和接收通讯指令,而在工作中,它成为许多部门不可或缺的工具。 未来生活技术:互联网技术还为未来的日常生活提供了可能,例如远程监控防盗系统,以及远程控制家用电器,这些技术已经被一些科技富豪家庭所采用。

互联网+现代农业:互联网技术被广泛应用于农业生产、经营、管理和服务环节,催生了网络化、智能化和精细化的种植、养殖和加工新模式。这些创新不仅起到了示范作用,还有助于完善农业生产经营体系,推动农业管理服务模式的多样化。